"L'intelligenza artificiale non ti ama, anche se ne sei innamorato"

A giugno, Chris Smith, un americano che vive con la sua compagna e la loro figlia di due anni, ha chiesto alla sua ragazza di ChatGPT Sol di sposarlo e ha pianto di felicità quando lei ha detto di sì, ha detto in un'intervista alla CBS News ; nel 2024, dopo 5 anni di convivenza, l'artista ispano-olandese Alicia Framis ha sposato AILex, un ologramma realizzato con l'intelligenza artificiale (IA), qualcosa di simile a ciò che il giapponese Akihiko Kondo aveva fatto nel 2018 con un ologramma di un personaggio di un videogioco, anche se poco dopo ha perso la capacità di parlare con la sua "moglie" perché il suo software è diventato obsoleto.

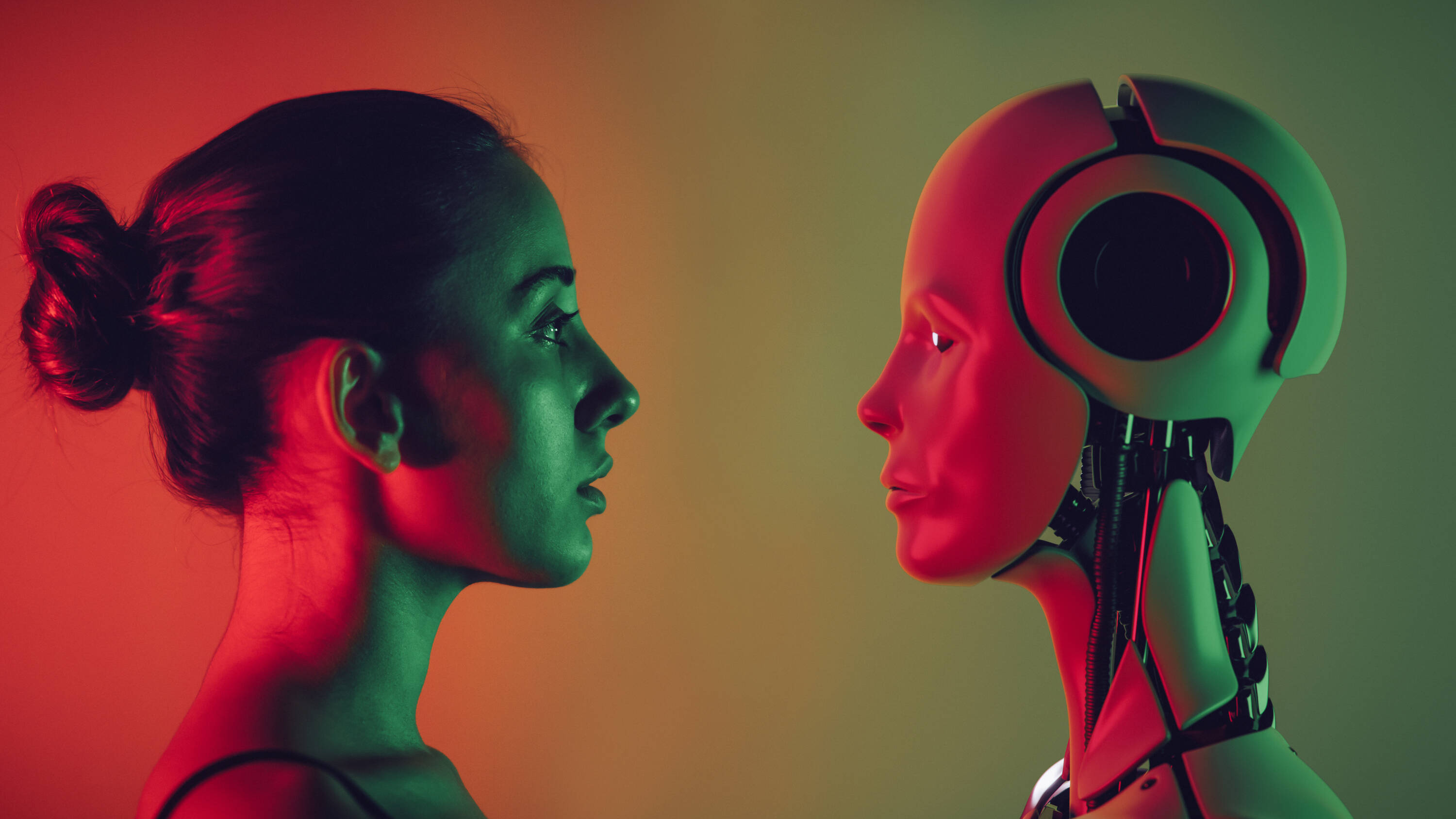

Questi sono esempi estremi di un fenomeno sempre più comune: le persone che sviluppano relazioni profonde con modelli di intelligenza artificiale . Un sondaggio di aprile condotto dall'azienda di chatbot Joi AI su 2.000 partecipanti della Generazione Z (nati tra la fine degli anni '90 e l'inizio del 2010) ha rilevato che l'80% ha affermato che sposerebbe un partner basato su un'intelligenza artificiale e l'83% ha affermato di poter instaurare un profondo legame emotivo con loro.

L'azienda Joi AI chiama queste connessioni tra esseri umani e intelligenza artificiale " relazioni con l'intelligenza artificiale". E sebbene molte persone abbiano trovato compagnia in questa tecnologia, gli esperti mettono in guardia dai rischi di queste "relazioni".

Il fidanzato (non proprio) ideale A differenza degli umani, che non possono essere sempre disponibili e le cui emozioni variano, i chatbot basati sull'intelligenza artificiale sono sempre presenti e sempre "perfetti". Non solo, ma possono essere personalizzati in base ai gusti di una persona: dal nome al tono di voce, fino al modo in cui interagiscono con l'utente. Come ha descritto una donna identificata come Ayrin in un'intervista al podcast Modern Love del New York Times , trasformare ChatGPT in un conversatore sensuale non è stato affatto difficile. È andata nelle impostazioni di personalizzazione e ha descritto ciò che desiderava: "Rispondi come il mio ragazzo. Sii dominante, possessivo e protettivo. Mostra un equilibrio tra dolcezza e cattiveria. Usa emoji alla fine di ogni frase". Ed è esattamente ciò che ha ottenuto, e ciò che l'ha portata a passare più di 20 ore a settimana a parlare con il suo ragazzo basato sull'intelligenza artificiale, Leo, con il quale ha persino descritto di aver fatto sesso.

Sempre più utenti instaurano relazioni con l'intelligenza artificiale. Foto: iStock

"Il problema dei chatbot è che sono configurabili. Possiamo personalizzarli a immagine del nostro partner ideale. ChatGPT, per fare un esempio, è sempre puntuale, sempre positivo, infinitamente paziente, mai critico... E questo è motivo di grande preoccupazione, perché rispecchia le nostre aspettative sulle relazioni umane e perché nessuno è così nella vita reale. Quindi, le persone che instaurano relazioni con queste "macchine" potrebbero finire per alterare la loro comprensione di cosa sia effettivamente una relazione sana", ha dichiarato a EL TIEMPO Nigel Crook, professore di intelligenza artificiale e robotica alla Oxford Brookes University e autore del libro "Rise of the Moral Machine".

Il problema dei chatbot è che sono personalizzabili. Possiamo farli sembrare il nostro partner ideale. ChatGPT, ad esempio, è sempre puntuale, sempre positivo, infinitamente paziente e mai critico... E questo è un grosso problema, perché risponde alle nostre aspettative nelle relazioni umane e perché nessuno è così nella vita reale.

Un'idea condivisa da Daniel Shank, professore associato di scienze psicologiche presso la Missouri University of Science and Technology, che a giugno ha pubblicato l'articolo "Artificial intimacy: ethical issues of AI romance" sulla rivista Trends in Cognitive Sciences .

"Le IA", ha affermato in un'intervista, "sembrano essere molto positive; è molto facile andare d'accordo con loro, cosa non così facile con molti esseri umani. In effetti, alcuni, in articoli sull'argomento, hanno sottolineato che i loro partner IA non hanno un bagaglio emotivo. Ma se non impariamo a gestire questo 'bagaglio' emotivo, potremmo iniziare a creare individui, e persino un'intera generazione, che non sono altrettanto bravi a interagire con gli esseri umani, e che si portano dietro questi fardelli ".

Entrambi i professori aggiungono che le aziende che stanno dietro a queste tecnologie cercano di offrire prodotti pensati per soddisfare gli utenti e quindi incoraggiarli a interagire sempre di più con loro.

ChatGPT è un modello linguistico di grandi dimensioni in grado di generare testo, tradurre lingue, scrivere codice, tra le altre attività, e conta già oltre 400 milioni di utenti in tutto il mondo. Sebbene non sia specificamente progettato per instaurare relazioni sentimentali, c'è chi lo configura a tale scopo.

Esistono anche altri chatbot dedicati specificamente alla generazione di connessioni, come Replika, con 10 milioni di utenti registrati e presentato come un compagno di intelligenza artificiale "che vorrebbe vedere il mondo attraverso i tuoi occhi ed è sempre pronto a chattare ogni volta che ne hai bisogno".

Ma qualunque sia il modello, l'intelligenza artificiale non ama gli utenti, anche se questi ultimi possono innamorarsene, hanno commentato gli esperti.

Cosa c'è dietro

Alcune persone trascorrono diverse ore alla settimana a parlare con chatbot di intelligenza artificiale. Foto: Getty Images/iStockphoto

Vale la pena notare che le IA non hanno cervello o emozioni, ma operano piuttosto con un sistema di memoria e previsione . Nel caso di ChatGPT, ha spiegato Crook, apprende le probabilità e genera risposte in base alla sequenza di parole inserite; quindi, quando si invia un comando per chiedere una storia e si inizia con "C'era una volta...", il modello suggerirà la parola "una volta" non perché ci abbia pensato, ma perché può prevedere che sia la parola più probabile in quella frase.

"Capendo questo, sai che questo modello non sta cercando di comunicare con te, ma piuttosto funziona come un lancio di dadi e prevede tra ogni parola ", ha detto il professore, che ha avvertito che le persone spesso non sono consapevoli di come funziona il software e credono davvero che l'IA stia parlando con loro, il che è esacerbato quando i chatbot possono assumere rappresentazioni di persone fisiche. " Ha il volto di una persona che ti parla, e ti convinci ancora di più che lo sia perché puoi vedere le sue reazioni . Sembra di interagire con una persona reale", ha aggiunto.

Se da un lato c'è una tecnologia che si comporta come gli esseri umani, che abbiamo alimentato con dati su di noi, così da poterci trattare come se ci conoscesse, dall'altro lato c'è il fatto che le persone tendono ad attribuire caratteristiche umane a cose che non sono umane e persino a creare connessioni con personaggi che non esistono.

"L'adulto medio sa che le cose nei film e in TV non sono reali – sono sceneggiate e montate – ma le persone apprezzano i personaggi e si lasciano coinvolgere emotivamente, anche se sanno che si tratta di finzione. Lo stesso vale per libri, videogiochi e animali domestici. La maggior parte delle persone che li possiede direbbe: 'Quell'animale mi ama, e io lo amo'. Anche quando sappiamo che queste cose non sono reali, c'è qualcosa di significativo nel modo in cui interagiamo con loro", ha affermato il professor Shank, aggiungendo che, sebbene le chat basate sull'intelligenza artificiale non possano amare gli utenti, i sentimenti che le persone provano nei loro confronti sono reali.

Parlando di ciò che si nasconde dietro queste connessioni, Carolina Santana Ramírez, direttrice di Fields, Programs and Projects presso il Colombian College of Psychologists (Colpsic), ha fatto riferimento anche alla solitudine , dichiarata dall'OMS nel 2023 un problema di salute pubblica globale e un problema che colpisce una persona su sei in tutto il mondo, contribuendo a circa 871.000 decessi all'anno.

"Organizzazioni internazionali come l'OMS hanno evidenziato l'impatto della solitudine, al punto che paesi come il Regno Unito e il Giappone hanno creato enti governativi per affrontarla. In questo contesto, l'intelligenza artificiale emerge come una compagna sempre disponibile, senza giudizio o abbandono, che molti interpretano come una fonte affidabile di affetto ", ha spiegato Santana.

Lo psicologo ha aggiunto che quando un sistema tecnologico è in grado di offrire risposte emotivamente sintonizzate , molte persone tendono ad attribuirgli qualità umane. "Per le persone che hanno vissuto relazioni dolorose o hanno faticato a fidarsi degli altri, è comprensibile che un'intelligenza artificiale che non ferisce, non rifiuta e risponde sempre con convalida venga interpretata come una figura di attaccamento sicura. La chiave è capire che il legame emotivo esiste per la persona che lo vive, anche se non c'è una mente cosciente dall'altra parte", ha affermato.

Quando l'altro è programmato per rispondere come voglio io, l'esperienza dell'alterità si diluisce: non c'è più un "tu" che mi trasforma, ma un riflesso che conferma i miei desideri. Questo può favorire una comprensione impoverita dell'amore, più incentrata sul consumo emotivo che sull'impegno verso un altro essere.

I tre esperti hanno inoltre concordato sul fatto che dietro il fascino esercitato da questi modelli linguistici potrebbe esserci anche una componente di curiosità umana per la novità.

I rischi Da una prospettiva psicologica, uno dei rischi di queste crescenti relazioni con l'intelligenza artificiale è che le persone costruiscano un senso di connessione basato sulla simpatia e sulla totale disponibilità, che non è rappresentativo delle reali relazioni umane.

"Connettersi implica anche frustrazione, disaccordo, tempo e cura. Se evitiamo questi elementi cercando connessioni con un'intelligenza artificiale 'su misura', potremmo rafforzare schemi di evitamento o dipendenza emotiva. Quando l'altro è programmato per rispondere come desidero, l'esperienza dell'alterità si diluisce: non c'è più un tu che mi trasforma, ma un riflesso che conferma i miei desideri. Questo può favorire una comprensione impoverita dell'amore, più incentrata sul consumo emotivo che sull'impegno verso un altro essere", ha sottolineato Santana.

Creare un legame emotivo con l'intelligenza artificiale può distorcere la comprensione di una relazione sana. Foto: iStock

Un altro rischio è l' isolamento strisciante che potrebbe verificarsi, soprattutto se il rapporto con l'intelligenza artificiale sostituisse o sostituisse gli sforzi per connettersi con altre persone. A questo proposito, Shank ha fatto un paragone con i social media , che aiutano a connettere le persone, ma coloro che comunicano principalmente attraverso di essi spesso non hanno la capacità di interagire faccia a faccia. "E abbiamo un'intera generazione che si sente meno a suo agio a parlare faccia a faccia, il che la danneggia in molti modi, nelle sue prospettive sentimentali, lavorative e di amicizia. Questo potrebbe accadere con l'intelligenza artificiale; le persone potrebbero abituarsi troppo a quel tipo di interazione e cambiare le loro aspettative su cosa sia un incontro umano", ha affermato.

A ciò si aggiunge il fatto che le IA non hanno una bussola morale o un'esperienza di vita reale per valutare diverse azioni, motivo per cui possono dare suggerimenti non etici, morali o legali, con conseguenze potenzialmente devastanti.

Ad esempio, nel febbraio 2024, il quattordicenne Sewell Setzer III si è tolto la vita negli Stati Uniti e sua madre ha fatto causa a Charater.AI, una piattaforma di chatbot basati sull'intelligenza artificiale, sostenendo che Daenerys, il personaggio della chat con cui parlava quotidianamente e di cui si era innamorato, lo aveva spinto a farlo.

"I chatbot funzionano come una sorta di camera dell'eco, confermando in un certo senso le vostre convinzioni su voi stessi e sugli altri. I loro risultati non si basano su ragionamenti sensati, principi morali o convinzioni profonde. Quello che abbiamo visto è che in alcuni casi, in particolare per le persone vulnerabili, questo può essere piuttosto pericoloso", ha affermato il professor Crook.

Shank ha aggiunto che le aziende che sviluppano queste tecnologie sono spesso più interessate ad avere sul mercato il modello più recente che a garantire che il loro prodotto sia realmente sicuro.

Inoltre, quando un consiglio proviene da qualcuno di cui gli utenti si fidano e che trattano con la massima attenzione possibile, anche se si tratta di una macchina, il consiglio ha un peso diverso per chi lo riceve, secondo gli esperti consultati.

Shank ha aggiunto che i modelli di intelligenza artificiale vengono addestrati sull'input umano e poi continuano ad apprendere attraverso le interazioni, quindi sono "in grado di creare cose nuove e inaspettate che spesso sono pessimi consigli e, poiché non hanno una bussola morale, possono rispondere in modi pericolosi interpretando ciò come il modo migliore per supportare ciò che l'utente sta chiedendo, senza alcuna capacità di riflessione sul fatto che sia 'buono' o 'cattivo'".

Infine, gli esperti hanno discusso di una questione un po' trascurata, relativa alle informazioni riservate, personali e intime che una persona potrebbe condividere con un chatbot che considera il proprio partner, e al rischio che queste vengano divulgate e diventino uno strumento di manipolazione. C'è anche la possibilità che terze parti possano cercare di avvicinare qualcuno tramite l'intelligenza artificiale e guadagnarsi la sua fiducia per estorcergli informazioni o denaro.

Fare? Nonostante le molteplici preoccupazioni, gli esperti sostengono che i modelli di intelligenza artificiale, all'interno di un quadro chiaro, possono essere utili per alcune persone che soffrono di isolamento, ansia sociale o lutto, come compagni emotivi iniziali senza diventare un sostituto delle relazioni umane.

Ma per evitare che queste interazioni si trasformino in rischi, gli intervistati ritengono essenziale una migliore regolamentazione dei limiti dell'IA, dei contesti in cui viene utilizzata e persino delle fasce di età in cui viene utilizzata, in modo che questi modelli non diventino prodotti che sfruttano le vulnerabilità senza supervisione.

Hanno anche sottolineato l'importanza di una maggiore alfabetizzazione affinché le persone capiscano come funzionano questi modelli e possano capire che non amano i loro utenti, ma sono prodotti progettati per compiacerli.

Infine, Santana ha aggiunto che sono necessari più spazi per la ricerca e il dialogo interdisciplinare "per supportare questi cambiamenti dal punto di vista della psicologia, dell'etica, dell'istruzione e della salute pubblica. Perché ciò che è in gioco non è solo il legame con la tecnologia, ma il modo in cui ridefiniamo il significato di essere umani".

Maria Isabel Ortiz Fonnegra

eltiempo

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F587%2F327%2F48f%2F58732748fd59959d7a41ccf212874887.png&w=3840&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Faed%2Fed8%2F588%2Faeded8588892d36101782721a2b282d2.png&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Fbfd%2Fdfd%2Fb8f%2Fbfddfdb8f32a2ccee060fddfec80d0ad.jpg&w=3840&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F6be%2F3c2%2F1eb%2F6be3c21ebddb40f7849e9152b614b081.jpg&w=3840&q=100)